新科技速遞| AWS 與 NVIDIA 策略合作 全新超級電腦

Table Of Contents

NVIDIA和AWS在 Project Ceiba上合作,設計全球最快 GPU驅動AI 超級電腦以及最新的 DGX Cloud 超級電腦,供 NVIDIA 的AI 研發與自訂模型開發服務

**[新科技速遞]**

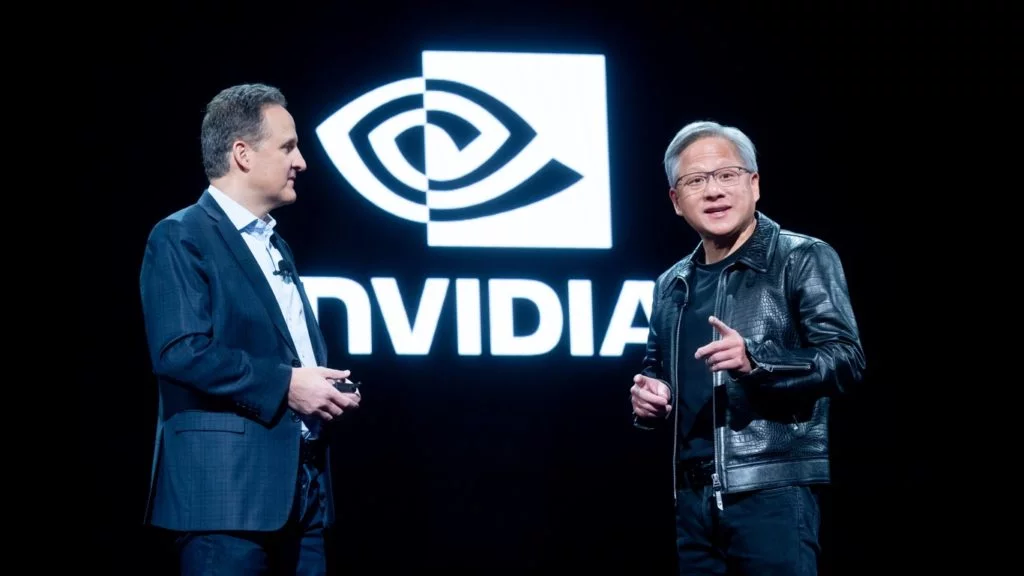

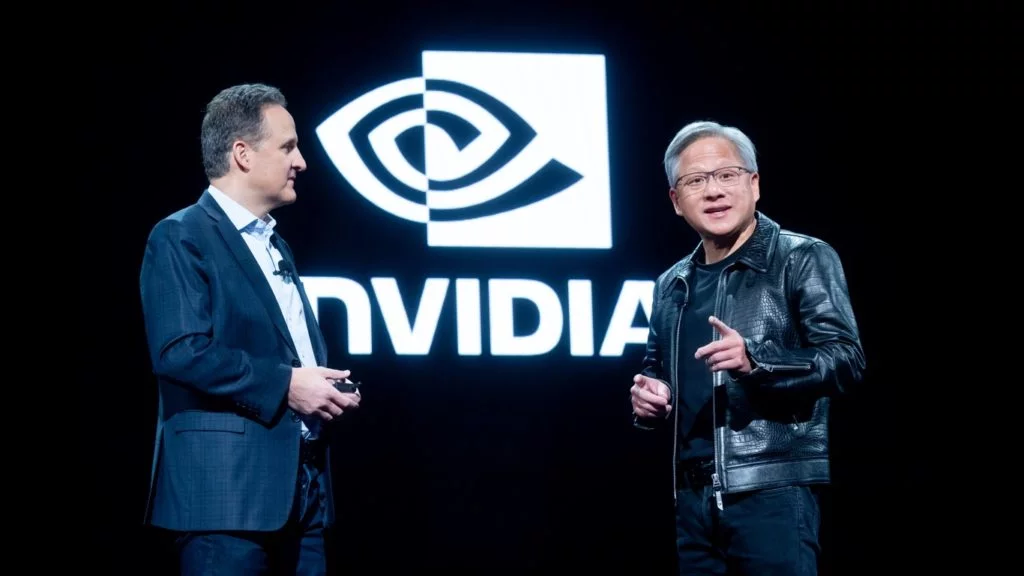

全球雲服務在打一場沒煙硝的戰爭,不過大家只一家軍火商,就是輝達(NVIDIA)。AWS在今年re:Invent 大會重頭戲是生成式AI,推出大量服務,站台也是輝達的創辦人黃仁勳。

Microsoft押注130億美元的OpenAI而一騎絕塵,雲服務Azure的OpenAI Services和Copilot成為王牌,據說OpenAI大模型再有突破,導致董事會分裂辭退Sam Altman。

生成式AI將改變一切,全球最大雲服務AWS不敢輕敵,re:Invent 大會上,行政總裁 Adam Selipsky在主題演說中,公佈多項生成式 AI合作。

實際上,Selipsky指生成式 AI可分三個層面,底層用於訓練大型語言模型的硬件,包括GPU和專用於人工智能晶片的Instance,亦包括SAGEMAKER工具,中間層提供對基礎模型的連接方式,構建和擴展生成式 AI 應用程式的工具。頂層是構建大模型應用,毋須任何專業知識,就可建立生成式 AI應用。

**中美差距漸行漸遠**

生成式 AI最重要是算力,大模型訓練和推論都消耗大量算力,輝達GPU壟斷了大模型9成算力市場。H100 是目前訓練大模型主流GPU,取價三萬美元,比上一代A100快30倍,遭限制輸華,據報華為昇騰910B 只能與A100看齊,可見中國AI算力差距嚴重。

AWS 推出首款結合 NVIDIA研發的Grace Hopper Superchip 超級晶片與 AWS UltraCluster 擴充技術的 AI 超級電腦,Grace Hopper Superchip結合了NVIDIA自家的 ARM處理器和H200系列GPU,有條件成為下一代超級電腦的主流架構。此外,DGX Cloud率先配備GH200 NVL32, 並將在首次 AWS 上提供此AI訓練即服務。

黃仁勳在re:Invent大會上介紹了在AWS的合作,包括在雲端釋放的算力,可訓練多達一兆參數的大模型。

AWS是首家在雲服務推出輝達GPU加速運算的instance,對GPU技術掌握先 ,雙方合作長達 13 年。GPU 執行平行運算,以浮點運算執行大型矩陣和向量運算,GPU用途涵蓋了繪圖、遊戲、高效能運算、機器學習,真正令GPU應用爆發是深度學習,因為矩陣和向量運算,繼而催生了生成式 AI的大潮。

**雲端超級電腦**

今年,AWS是首家推出配備H100的P5 instances雲服務,利用第三代AMD的EPYC處理器,P5算力極為驚人,配合AWS網絡技術和Nitro虛擬化與安全晶片,達 3,200 Gbps低延遲網絡流量, EC2 UltraCluster支援達20,000片 H100 GPU,算力達 20 exaFLOPS。

輝達與 AWS再深度合作,特點是利用輝達新一代 GPU、CPU 與 AI 軟件多節點技術,也就 是整個軟硬件堆疊都是輝達,配合AWS 的 Nitro平台及安全虛擬平台、Elastic Fabric Adapter(EFA)互連介面、以及 UltraCluster 擴充服務,變成雲端超級電腦。部分企業或初創或會自行訓練大模型,Grace Hopper Superchip與 AWS UltraCluster 擴充的 AI 超級電腦,首先肯定是供大模型訓練。

AWS有不少AI獨角獸,變成AWS服務銷售, 包括由前OpenAI員工所創立的Anthropic,訓練出Claude的2.1 版本大模型。Selipsky說,全球有一千家估值超過十億美元的獨角獸,其中八成都利用AWS,包括了Ultima Genomics將基因排序的成本降六成,都是利用了AWS的AI算力。

**瀏覽器連接出租算力**

Grace Hopper架構是輝達自行開發,支援NVLINK,採用ARM架構CPU的架構;功耗比x86架構更低,支援輝達多節點 NVLink 技術設計,可建立晶片至晶片直接互連,每秒連接速度高達 1 TERABYTE, GPU 可存取CPU所有記憶體,CPU亦可訪問GPU 所有記憶體,充份利用兩者算力,減少怠轉的時間。

輝達與 AWS 將在 AWS 推出首個採用 GH200 NVL32 的 DGX Cloud 推出「訓練即服務」(AI-training-as-a-service)方案,輝達稱 DGX Cloud為AI工廠,屬於超級計算集群,搭配輝達AI 軟件,標榜透過瀏覽器,就可向用戶出租AI 算力。運行單一instance的情況下,DGX Cloud可訓練出超過 1 兆參數的大型語言模型。GH200 NVL32 是以機櫃形式,運用NVLink 與 NVSwitch 技術連結起 32 枚 Grace Hopper 超級晶片GH200,可擴充至配備上千顆 GH200 超級晶片的規模。

**雲上建最快AI 電腦**

訓練大語言模型需求日高,傳統超級電腦設計,並不針對AI訓練,加入AI的超級電腦應運而生,輝達在超級電腦榜單上地位日隆。

輝達與 AWS 正合力推動 Project Ceiba,聯手設計全球最快的GPU驅動的 AI 超級電腦。Project Ceiba超級電腦配備 GH200 NVL32機櫃 與 EFA 互連技術,支援16,384片GH200 超級晶片,具備65 exaflops 速度的 AI 運算能力,相等於65部超級電腦,由 AWS 代管供輝達研發團隊服務,可望成為全球最快 GPU驅動的AI 超級電腦。

值得一提是輝達較早前公佈,德國EuroHPC建立JUPITER系統會採用 Grace Hopper 超級晶片GH200,AI 運算能力達90 exaflops,英特爾宣佈為美國能源部開發訓練1 兆參數大型語言模型的Aurora超級電腦。全球超級電腦愈來愈多採用輝達的H200,加上H200配備了美光專門供LLM訓練的記憶體HBM3e,英特爾在超級電腦的市場正受嚴重挑戰。

上月公佈的超級電腦Top500榜單之中,379部利用輝達GPU,49部剛入榜超級電腦之中,38部採用輝達,即使不是利用GH200,現時超級電腦亦會將原本H100升級至 H200。隨著軟件架構升級,輝達的GH200 NVL32稱霸高性能運算市場,似乎指日可待。

NVIDIA和AWS在 Project Ceiba上合作,設計全球最快 GPU驅動AI 超級電腦以及最新的 DGX Cloud 超級電腦,供 NVIDIA 的AI 研發與自訂模型開發服務,配備 NVIDIA GH200、H200、L40S、以及 L4 GPU 等核心的全新Amazon EC2 instances,將大幅提升生成式 AI、高效能運算、設計、以及模擬的工作負載效能。

**生成式AI應用**

黃仁勳稱DGX Cloud是 AI工廠,一點也不為過,因為 AWS 上運行的 NVIDIA 軟件,包括 NeMo LLM 框架、NeMo Retriever、以及 BioNeMo,可加速發展自訂模型、語意檢索、新藥研發等應用的生成式 AI。

AWS 推出三款 Amazon EC2 instances:P5e instance配置H200,針對生成式 AI 及 HPC 運算;以及配置多用途的L4 與L40S 的 G6 與 G6e instance,針對 AI 微調、推論、繪圖、以及影片剪輯。G6e instances特別適合開發 3D 、數碼孿生、以及使用 NVIDIA Omniverse 應用,連結與構建各種生成式 AI 的 3D 應用。

AWS 行政總裁 Adam Selipsky 表示:「 AWS 運用 NVIDIA 技術推動創新,結合新一代 NVIDIA Grace Hopper 超級晶片與 AWS 的 EFA 、EC2 UltraClusters 超大規模叢集、以及 Nitro 虛擬化和保安功能。」

AWS 上運行的 NVIDIA 軟件亦幫助 母公司Amazon 創新服務營運;Amazon運用NeMo 框架訓練新一代Amazon 自家制Titan 大模型,Amazon Robotics 運用 Omniverse Isaac 構建數碼孿生,虛擬環境規劃Amazon無人倉,再遷移至真實場境。

不過AWS也推出新一代自研AI晶片,包括 Graviton4 和 Trainium2,針對機器學習(ML)和生成式 AI訓練,有更高性價比和能源效益,不少提供機器學習和訓練初創,透過專用AI晶片降低成本,實行大小通吃。